复旦大学徐英瑾教授来我院讲座

点击次数: 更新时间:2020-12-07

本网讯(通讯员 田昶奇)2020年12月4日晚上7点,复旦大学哲学学院徐英瑾教授应邀,为武汉大学哲学学院作了主题为《通用人工智能需要在私人语言的层面上进行知识表征吗?》的线上讲座。本次讲座由外国哲学教研室潘磊副教授主持,校内外师生180余人参与了本次讲座。

徐英瑾教授首先论述了当前人工智能研究没有完成构造主观性的任务。智能的最大特点是具有个体性,正因此,人们很难预报一个智能的人在具体环境中会做出什么。然而,人工智能研究中存在的两种客观主义路线无法构造主观性,进而不能呈现个体性。第一种客观主义路线是传统符号主义进路,这种进路下的人工智能是相关编程作业所设计的虚拟模型,被假设为对于客观世界的某个特定面相的摹写;第二种客观主义路线是基于大数据的深度学习模型,深度学习所模拟的就是大量的人类个体在特定输入与输出之间的映射习惯,因此仍是某种康德式的意义上的客观主义路线(康德主义意义上的客观性所意指的即大量主观性的交错重叠之处)。徐教授总结,从语言哲学的立场上看,第一个版本的客观主义属于柏拉图-弗雷格路线的意义观,而第二个版本的客观主义则与后期维特根斯坦的意义观有所关联。然而,这两种客观主义的意义观都无法解释为何某些个体的智能能够超越客观性的窠臼而另辟蹊径,因此需要恢复某种版本的主观主义的意义观传统。

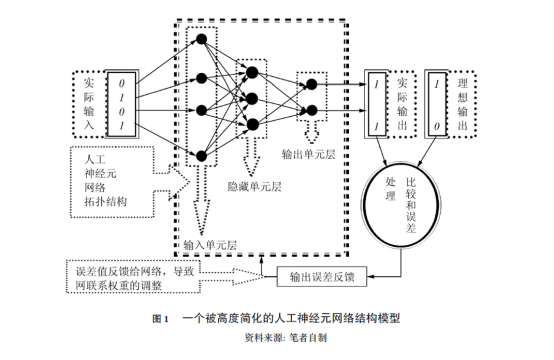

徐英瑾教授指出,人工智能研究目前有专家系统(expert system,先将一个特定知识领域内的专家知识用逻辑语言加以整编,然后利用逻辑推理规则推演出对用户有用的特定结论)与联结主义-深度学习技术路径(用数学建模的办法建造出一个简易的人工神经元网络结构)两种路径,前者支持客观主义-第三人称的知识表征,后者则不支持,但这并不意味着它就支持主观主义-第一人称知识表征。不过,徐教授接着指出,通用人工智能(Artificial General Intelligence,简称AGI)能支持主观主义-第一人称知识表征,理由在于:如果AGI系统能够在开放的环境下进行自主化运作,那么该系统就需要有能力随时根据最新的情况更新自身的知识库,并对未来还未发生的新情况进行合理的预期,而这些就是记忆、怀疑、展望等典型人类主观性心理能力;由于不同的AGI系统所各自面临的生存环境的差异,基于不同环境互动历史的生存策略就会在不同系统的“主观性”面相上打下自己的烙印,由此使得第一人称视角成为AGI系统的某种不可或缺的特征。

解释完AGI系统为何能支持主观性-第一人称视角后,徐英瑾教授指出,AGI语境中对于第一人称视角的重建会不容于后期维特根斯坦对于私人语言的批判。为了回应该批判,徐教授引入大森庄藏哲学。大森庄藏和维特根斯坦都提到了“暹罗连体人案例”(两个人共用一具身体),但深层用意却南辕北辙,维特根斯坦提是为第三人称视角(或曰“公共视角”)的基本性提供辩护,大森庄藏却是为第一人称视角的基本性提供注脚。徐教授基于AGI角度,将大森庄藏的论述重构为两种论证:1.基于不同的信息处理系统的空间局域性的论证;2.基于不同的信息处理系统的运行历史的特异性的论证。第一个论证得出对于不同的AGI系统A与B来说,他们各自基础输入数据集之间的差异就会导致它们所要把握的概念的含义的区别(无论这种区别有多细微)。第二个论证得出对于某个公共符号甲来说,任何一个AGI系统对于它的把握方式,都会与另外一个AGI系统对于它的把握方式有所不同。

徐英瑾教授补充说,根据上述论证,尽管不同的AGI系统有不同的主观性,但这并不意味着它们彼此不能不能完成有效的沟通。在这里徐教授区分了“有效沟通”和“彻底相互理解”。AGI系统之间实现有效沟通,即对于符号甲的理解方式来说,A与B各自的理解方式只要彼此重叠到一定程度,就能够进行比较有效的沟通了,而不论它们各自的理解方式在重叠区之外还有哪些分殊。大森庄藏本人用了一个视觉隐喻色彩浓郁的术语“叠加描绘”,来描述这种使得公共交流得以可能的机制。

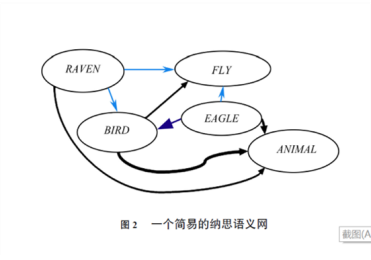

为了在技术背景中实现大森庄藏的想法,徐英瑾教授引入了纳思系统(NARS)来重构AGI意义上的私人语言的可能性。徐教授认为纳思系统所运用的纳思逻辑与亚里士多德式的词项逻辑之间的亲缘关系,要明显强于其与弗雷格式的现代逻辑之间的亲缘关系,这体现于纳思系统认为一个最简单的判断或信念乃是由两个概念节点构成的。在纳思系统下,机器表征系统下的私人语言就是:一个机器表征系统中至少有一个这样的子集:该子集只能被一个特定的AGI系统所充分理解,而不能被任何一个其它的AGI系统所充分理解。又由于任意两个AGI系统之间的概念推理结构几乎不可能完全一致,故而私人语言在AGI的内部表征中的出现,便是某种常态。AGI系统之间的概念推理结构不可能完全一致,局域性原则与历史性原则,这两条原则分别对应于徐教授重构的大森庄藏论证一与论证二的基本前提。

在互动环节中,三位听众就讲座内容提出问题:

听众A:深度学习能否代替纳思系统构造主观性的作用。

徐英瑾教授认为主观性不只是主观的感觉材料,而在于背后的意向系统,为此要做出人的整个心理过程,但深度学习做不到这一点;因此,对于构造主观性,深度学习只能承担次要作用而非主要功能。

听众B:在捍卫人工智能的主观性时,能否把情绪这些角色纳入人工智能。

徐英瑾教授认为人工主观性的主观性可以纳入情绪。徐教授以恐惧为例,人类的恐惧感所体现的法则是面对威胁自己生命安全的情况时会有相应行为,相应地,人工智能在潮湿环境下(潮湿会导致短路,进而导致任务无法执行),也会产生相应的恐惧感。

听众C:徐教授的主观性进路与德雷福斯所代表的具身性的区别。

徐教授认为具身性与他的相同点在于身体性是徐教授所主张的局域性原则与历史性原则两条原则的中介,另一方面,核心编程的重要性也不亚于身体,而这种重要性被具身性淡化了。徐教授以亚里士多德的“中道”作类比,身体类似于质料,核心编程类似于形式,二者都重要。

最后,潘磊老师代表哲学学院师生对徐英瑾教授这场深刻而精彩的讲座表示了感谢。同学们表示,此次讲座收获颇丰。

(编辑:邓莉萍 审稿:严璨)